Tutti i trend dell'AI li paghiamo con la nostra privacy

Il costo nascosto delle foto in stile Ghibli o le action figure fatte a nostra somiglianza. «Per queste aziende siamo una miniera d'oro».

I pochissimi che non lo hanno fatto è stato solo per rispetto nei confronti del maestro Miyazaki che, fin da subito, ha giudicato l’operazione come lesiva della propria arte. Tutti gli altri hanno invece condiviso sui social network la propria immagine rielaborata in stile Studio Ghibli. Un trend che ha letteralmente spopolato in Rete e che ha aperto non poche problematiche con riguardo al diritto d’autore.

Passata la mania Ghibli, da alcune settimane ci si rivolge all’intelligenza artificiale per creare le proprie action figure, ossia se stessi in formato bambola, con tanto di accessori personalizzati e scatola. Si stima che le ricerche su come poter seguire tale trend siano aumentate del 2.600% in pochi giorni, tanto che lo stesso Sam Altman, CEO di OpenAI, così come riportato da Io Donna, ha giudicato tale fenomeno «una vittoria netta» per la propria azienda, a dispetto di tutte le critiche ricevute sulla creazione di immagini e opere artistiche grazie all’intelligenza artificiale. Tale trasformazione è infatti possibile grazie a un nuovo generatore di immagini dell’azienda, alimentato da GPT-4.0, che ha aumentato in maniera esponenziale la capacità di elaborazione grafica di ChatGPT.

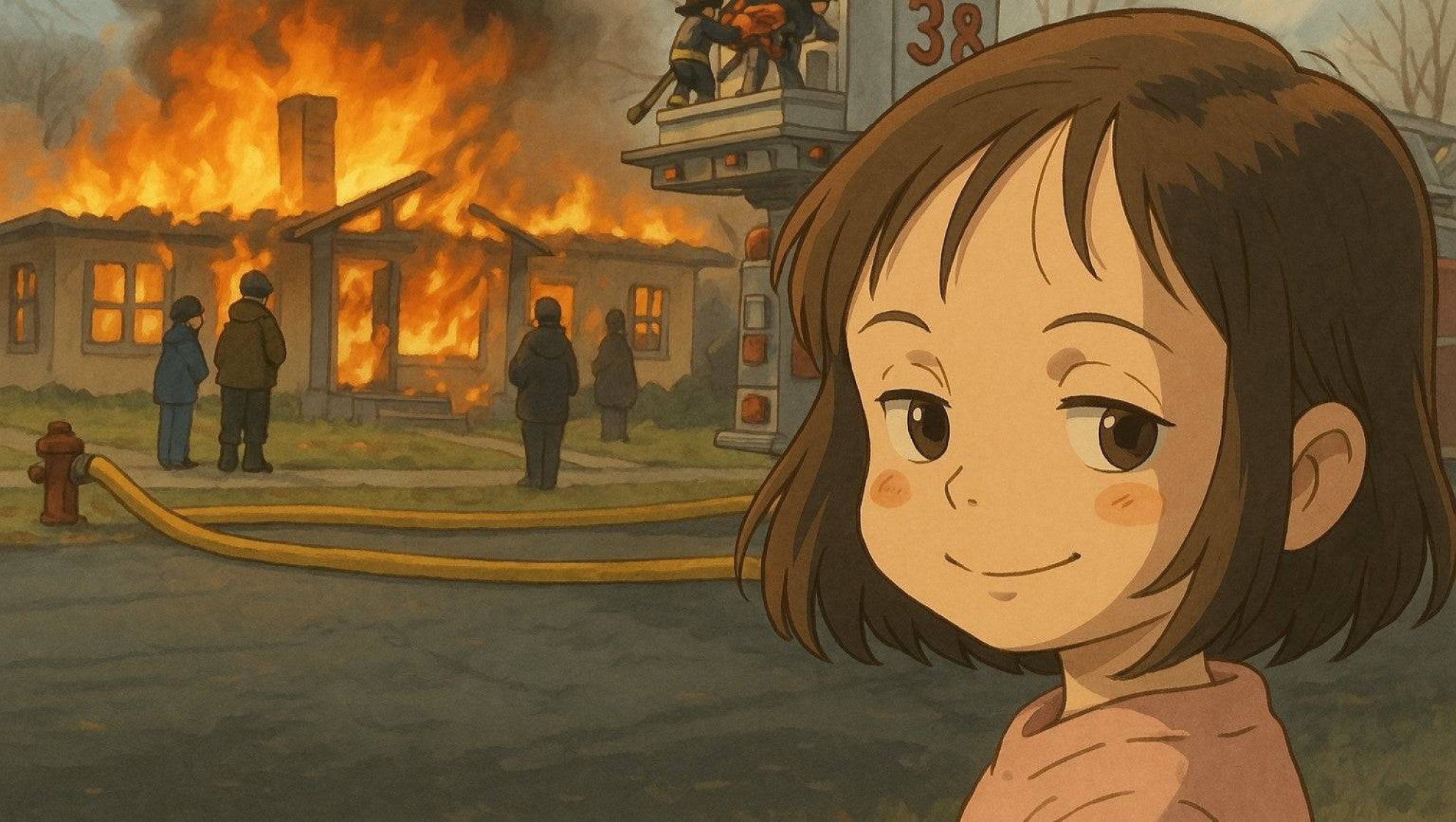

Imago/Newscom/GdaIl meme della “disaster girl” passato per il “filtro Ghibli” di Chat GPT.

Imago/Newscom/GdaIl meme della “disaster girl” passato per il “filtro Ghibli” di Chat GPT.Il costo invisibile del trend dell'AI– Nessuno può negare che il vedersi in versione bambolina o disegno manga sia divertente, ed è difficile pensare che ci sia qualcosa di male nel modificare una propria immagine in questa maniera. Eppure, nell’era digitale, è cosa nota che le insidie si nascondano proprio dove uno meno se le aspetta. La moneta di scambio, come sempre avviene nel mondo digitale, è il nostro diritto alla privacy che cediamo, più o meno consapevolmente, per poter accedere a determinati servizi.

Su Huffington Post, la giornalista Monica Torres ha voluto sperimentare la creazione della propria action figure per poi rendersi conto che, tra gli accessori allegati nella scatola, fossero presenti un gatto arancione, dei narcisi e una torta, ossia dei suoi reali interessi. Il pericolo, a questo punto, come affermato da Dave Chronister, CEO della società di sicurezza informatica Parameter, «è quello di mostrare al mondo le cose di proprio interesse per poi essere preso di mira. Gli attacchi di ingegneria sociale sono ancora il modo più semplice e popolare per gli aggressori di prendere di mira una persona, dal punto di vista lavorativo e personale».

I metadati nascosti e la raccolta comportamentale – Anche dietro a un’attività apparentemente innocua come la creazione della propria action figure, quindi, si nasconde il pericolo di condividere degli aspetti della propria vita personale che potrebbero essere utilizzati, ad esempio, per delle pericolose truffe online. Come riferito da Wired, Tom Vazdar, responsabile dell’area di cybersecurity dell’Open Institute of Technology, ha detto chiaramente che ogni volta che si carica un’immagine su ChatGPT si regala a OpenAI «un intero pacchetto di metadati, tra cui i dati EXIF allegati al file inviato».

I file EXIF, infatti, sono una sorta di archivio che contiene tutte le informazioni relative a una data immagine, come l’ora e il luogo in cui è stata scattata e l’impostazione della fotocamera con la quale la foto è stata fatta. Secondo Vazdar, il dato fondamentale che gli utenti tendono a trascurare è che «le piattaforme come ChatGPT sono conversazionali, capaci di raccogliere anche dati comportamentali come quello che avete digitato, che tipo di immagini avete chiesto, come avete interagito con l’interfaccia e la frequenza di tutte queste azioni».

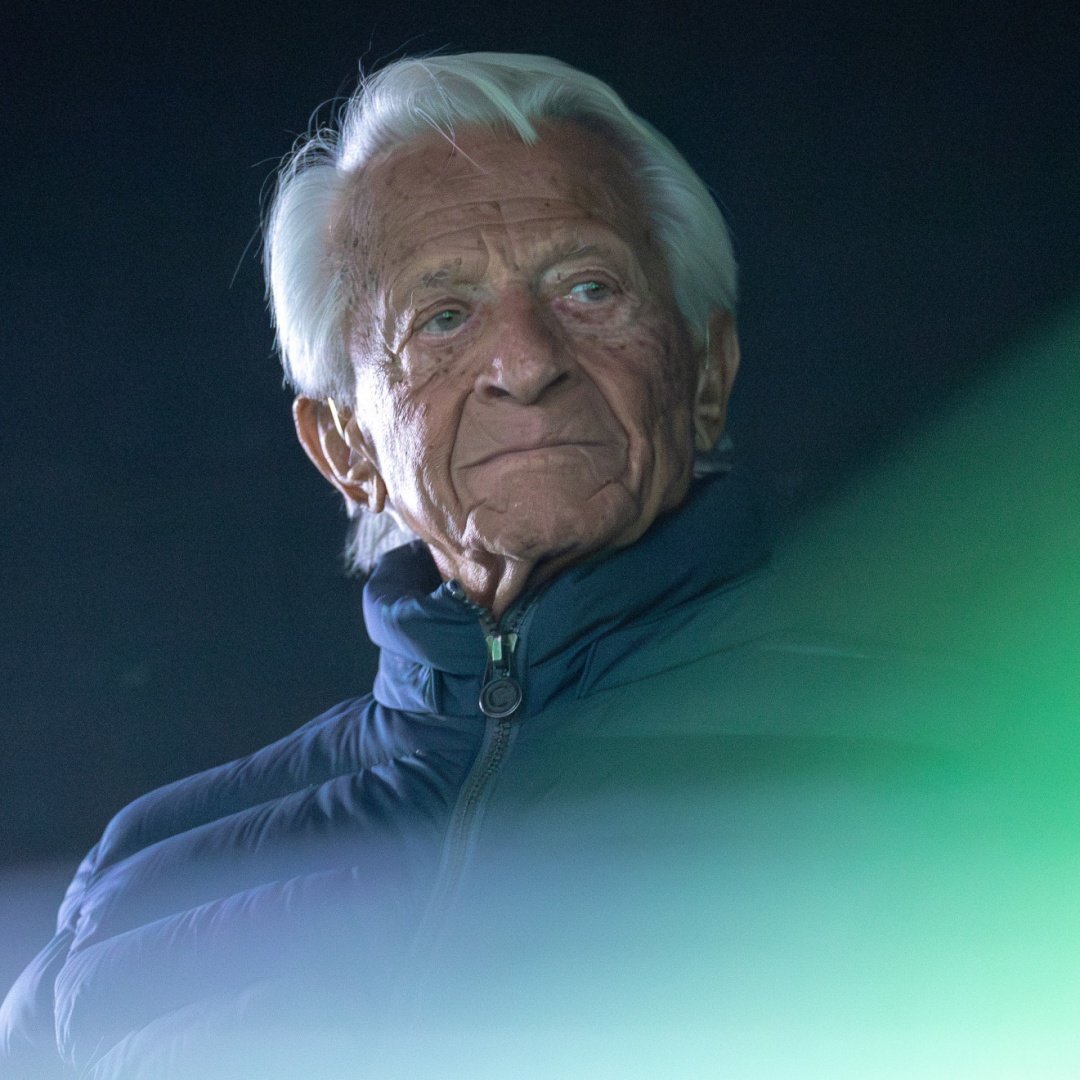

IMAGO/ABACAPRESSSam Altman, CEO di OpenAI appare davanti al Senato americano, nel maggio del 2023.

IMAGO/ABACAPRESSSam Altman, CEO di OpenAI appare davanti al Senato americano, nel maggio del 2023.Una miniera d’oro per i modelli generativi – Non si tratta soltanto di condividere banalmente una immagine, ma di permettere all’A.I. di conoscere degli aspetti della nostra privacy che abbiamo accettato di condividere per aver accesso a un servizio.

«Una vera e propria miniera d’oro per l’addestramento di modelli generativi», sottolinea Vazdar su Wired. Come è noto, l’A.I. conversazionale permette alle macchine di capire il linguaggio umano e di rispondere in maniera analoga, e vengono addestrate esponendo tale modello a miliardi di immagini, testi e schemi linguistici, affinché il loro interfacciarsi con le persone diventi sempre più complesso e verosimile.

Già lo scorso anno, la giornalista esperta di sicurezza informatica e privacy Kate O’Flaherty aveva lanciato l’allarme su Forbes sulla nuova funzionalità ChatGPT-4.0, sottolineando ancora una volta il fatto che ad ogni suo utilizzo ChatGPT raccoglie una serie di dati riguardanti l’utente, destinati a essere conservati per un tempo indefinito, al fine di addestrare il modello sui suoi gusti ed esigenze personali.

Qualsiasi aspetto della nostra vita personale condividiamo con ChatGPT, fosse anche la foto dei nostri familiari per essere trasformati in disegni in stile Ghibli, viene immagazzinato ed utilizzato dall’intelligenza artificiale per migliorare le proprie prestazioni future. I propri dati facciali, come ricordato da Io Donna, espongono l’utente al pericolo che essi siano copiati e divulgati su altre piattaforme, facilitando le truffe basate sul furto d’identità o la creazione di fake news.

Le implicazioni della privacy e l’uso dei dati – Fin dalla sua presentazione, nel maggio dello scorso anno, il nuovo modello di ChatGPT ha sollevato numerosi interrogativi riguardo a potenziali violazioni della privacy degli utenti, in considerazione della sua accresciuta capacità di confrontarsi in maniera molto «più umana» con i propri utenti.

Dopo il lancio di GPT-4.0, in una demo dell’app macOS ChatGPT Desktop era comparsa l’indicazione che il chatbot era potenzialmente in grado di accedere allo schermo dell’utente, mentre a luglio dello stesso anno era emerso un problema di sicurezza legato alla capacità del chatbot di memorizzare le chat contenute nei vari device.

D’altra parte, la stessa politica sulla privacy di OpenAI non fa mistero del fatto che l’azienda raccolga tutti i dati degli utenti e li utilizzi per addestrare i propri modelli, nonostante venga affermato che ChatGPT non abbia accesso al contenuto dei dispositivi, eccezion fatta per quanto scritto esplicitamente nella chat. In verità, come affermato su Wired US da Jules Love, fondatore di Spark, una società di consulenza sulle potenzialità dell’A.I., ChatGPT «usa tutto: dai prompt e risposte agli indirizzi e-mail, ai numeri di telefono, ai dati di geolocalizzazione, all’attività di rete e al dispositivo che stai utilizzando». Tali dati, inoltre, vengono condivisi dall’azienda con altre società affiliate o fornitori di servizi, motivo per cui è difficile capire dove e come verranno utilizzati i dati forniti a OpenAI.

IMAGO/SOPA

IMAGO/SOPAStrumenti di tutela dell’utente – I fruitori di ChatGPT, però, non sono privi di strumenti posti a tutela della propria privacy, studiati da OpenAI fin dal suo esordio nel 2020. Gli strumenti per salvaguardare i propri dati personali quindi esistono, anche se andrebbero conosciuti meglio. Prima di utilizzare il chatbot, sarebbe molto utile, ad esempio, scegliere nelle impostazioni di rinunciare all’addestramento dello stesso con i propri dati.

Sarebbe utile anche disattivare la cronologia delle chat o condividere delle immagini già modificate tramite l’uso di filtri o di un avatar digitale, invece che una vera. Il punto cruciale, come affermato da Jules Love, è quello di entrare nelle impostazioni personali e disattivare la raccolta dei propri dati. «Questo – come detto dal consulente – non rimuove i vostri contenuti dalla loro piattaforma, ma significa che non possono essere utilizzati per addestrare modelli futuri, dove esiste il rischio teorico della fuga dei dati». Chiaramente, una limitazione all’uso dei propri dati avrà come risultato una minore accuratezza e verosimiglianza delle risposte fornite dal chatbot, poiché l’intelligenza artificiale potrà attingere su di un numero più limitato di algoritmi generici.

Verso un uso consapevole dell’intelligenza artificiale – L’ideale, come in tutte le cose, sarebbe poter giungere a un uso equilibrato dell’intelligenza artificiale, sfruttandone le potenzialità anche a fini ludici, ma ben consapevoli delle conseguenze del suo utilizzo e dell’esistenza di strumenti che possono tutelare il nostro giusto diritto alla privacy.

Appendice 1

Gallery

Imago/Newscom/GdaIl meme della “disaster girl” passato per il “filtro Ghibli” di Chat GPT.

Imago/Newscom/GdaIl meme della “disaster girl” passato per il “filtro Ghibli” di Chat GPT. IMAGO/ABACAPRESSSam Altman, CEO di OpenAI appare davanti al Senato americano, nel maggio del 2023.

IMAGO/ABACAPRESSSam Altman, CEO di OpenAI appare davanti al Senato americano, nel maggio del 2023. IMAGO/SOPA

IMAGO/SOPA