Ogni anno si individuano sempre più video falsi. Il rischio: un futuro in cui non si distingua più il vero dal falso.

Che le immagini non possano mentire, è sempre stata una verità universalmente accettata. In barba alle bugie e ai mille modi che hanno le parole di nascondere la verità, gli occhi non ci ingannano e le immagini che ci restituiscono non possono che testimoniare un fatto accaduto realmente.

Ai giorni nostri, si sa, sono però poche le certezze che rimangono in piedi e anche questo assunto è miseramente caduto con l’affermarsi dei "deepfake". Con tale termine si intende la tecnica con la quale l’intelligenza artificiale può manipolare le immagini per creare falsi video e immagini.

KeystoneI deepfake individuati nel 2019 sono stati 14'678

KeystoneI deepfake individuati nel 2019 sono stati 14'678Cos'è il "deepfake" - In pratica, i volti, ma anche la voce, delle persone sono sovrapposte a scene già esistenti creando così dei veri e propri falsi. Il termine è stato coniato nel 2017 quando un utente di Reddit, un social media d'intrattenimento, che si era ribattezzato ‘deepfakes’ aveva iniziato a condividere video ottenuti con tale tecnica.

In principio fu la pornografia - Si tratta di un neologismo nato dalla combinazione del termine ‘fake’, ossia falso, e il termine ‘deep learning’, una particolare tecnologia d'intelligenza artificiale. In pratica, lui e altri utenti, condividevano i video in cui le immagini erano manipolate ad arte. In alcuni di essi, i volti di alcune celebrità erano montati sul corpo di attrici di film pornografici mentre in altri, di contenuto non pornografico, era sovente usato il volto dell’attore Nicholas Cage estrapolato da diversi film girati dallo stesso.

ImagoEra sovente usato il volto dell’attore Nicholas Cage

ImagoEra sovente usato il volto dell’attore Nicholas Cage Il danno era già fatto - Nel dicembre dello stesso anno, la giornalista Samantha Cole scrisse, sulla rivista Vice, del proliferare del fenomeno e anche se molti social, come Twitter o lo stesso Reddit, iniziarono a vietare l’uso dei deepfake, il danno era già fatto. Furono tantissime le persone più o meno famose che, loro malgrado, si trovarono invischiate in video assolutamente falsi.

«Un tunnel di tenebre» - L’attrice Scarlett Johansson, soggetto di numerosi video pornografici manipolati, parlò apertamente del problema sul Washington Post e affermò che internet era «un vasto tunnel spaziale di tenebre che si mangia da solo». Anche la politica internazionale non è stata immune dall’assalto dei deepfake: al presidente argentino Mauricio Macri fu sostituito il volto con quello di Adolf Hitler mentre Angela Merkel venne sostituita con Donald Trump.

Anche Barack Obama preso di mira - Anche Barack Obama è stato una vittima illustre del fenomeno: nel 2018 il comico Jordan Peele e Jonah Peretti crearono un video falso in cui l’ex presidente degli Stati Uniti d’America metteva in guardia le persone proprio sulla diffusione del deepfake. Il pericolo di tali video risiede nella loro capacità di minare la credibilità delle persone che ne sono vittime, infangandone l’integrità morale e distorcendone l’immagine pubblica. I deepfake sono infatti usati, principalmente, per motivi deprecabili quali la creazione, come visto, di falsi video pornografici, truffe, oltre che per compiere atti di cyberbullismo e altri reati informatici.

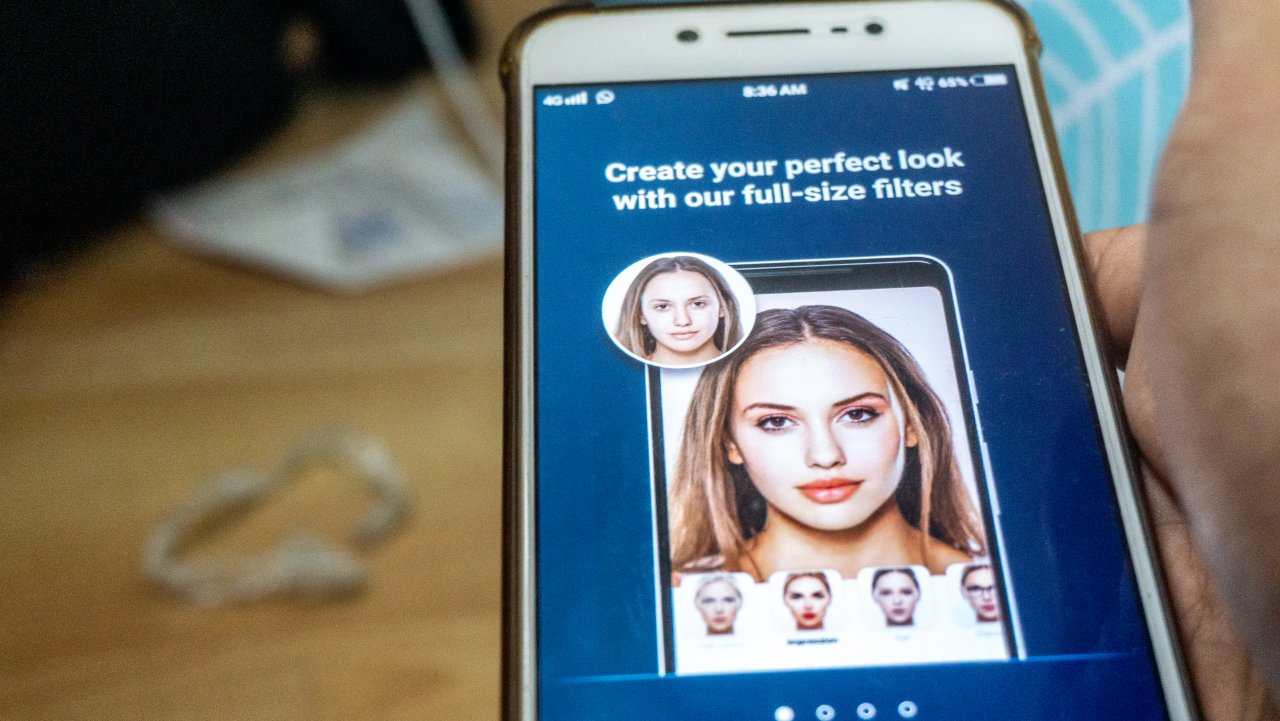

La tecnologia- Secondo Deeptrace, i video deepfake individuati nel 2019 sono stati 14'678, con un incremento dell’84% rispetto all’anno precedente. Nel 2018, infatti, erano stati individuati 7'964 file manipolati. Il 96% dei video deepfake condivisi nel corso del 2019 provenivano dal mondo del porno. Il meccanismo usato è simile a quello utilizzato da alcune applicazioni dello smartphone che consentono di modificare i volti delle persone, ad esempio invecchiandoli o aggiungendo alcune caratteristiche quali il trucco degli occhi o barba e baffi. Il risultato è quello di creare video in cui i visi e i movimenti delle persone sono modificate da un computer con risultati estremamente realistici al punto da rendere difficile il riconoscimento dei video veri da quelli falsi.

Deposit

DepositDovrebbe diventare un crimine specifico - Nel Regno Unito, per esempio, i produttori dei materiali deepfake possono essere perseguiti per molestie, ma vi è la volontà, lì come in altri Paesi, di configurarlo come un crimine specifico. È di pochi giorni fa la notizia secondo la quale Facebook avrebbe collaborato con gli studenti della Michigan State University, Msu, per creare un metodo che permetta di decodificare i deepfake con la tecnica del "reverse engineering".

Cos'è il "reverse engineering"? - Grazie a questo nuovo modello, è possibile analizzare le immagini generate da un'intelligenza artificiale e identificare, attraverso una serie di parametri predisposti ad hoc, le caratteristiche presenti generate dai modelli di apprendimento automatico, anche se sconosciuti. Il tutto si traduce in una sorta d'impronta digitale che permette d'indicare la veridicità o meno di un filmato. Si tratta di indizi digitali lasciati dal modello generativo che potranno essere usati per risalire alla provenienza delle immagini. L’assoluta novità è che partendo anche solo da una singola immagine del deepfake si potrà risalire al modello generativo seppur sconosciuto.

Risultati promettenti - La fase di ricerca non è ancora terminata, ma i risultati ottenuti sono molto promettenti. Il gruppo di lavoro ha analizzato 100mila immagini false generate da 100 modelli generativi disponibili al pubblico. I risultati del test hanno mostrato che il nuovo metodo di studio ha offerto risultati migliori rispetto ai sistemi realizzati in precedenza. Nonostante i risultati promettenti, però, si è ancora lontani dai risultati ottimali: l’algoritmo migliore ha rilevato il 65,18% dei video manipolati dall’intelligenza artificiale.

«In passato non avremmo potuto fare molto» - Tal Hassner, ricercatore di Facebook, ha illustrato in maniera molto efficace il nuovo modello al sito di notizie e informazione The Verge: «Supponiamo che un malintenzionato stia generando molti deepfake diversi e li carichi su piattaforme diverse - dice Hassner -. Se si tratta di un modello d'intelligenza artificiale che nessuno ha visto prima, allora c’era ben poco che avremmo potuto fare in passato. Ora, invece, potremmo dire "Questo è il colpevole"». «Il nostro metodo - ha affermato Xiaoming Liu, professore d'informatica della Michigan University - faciliterà il rilevamento e il tracciamento dei deepfake in ambienti reali in cui lo stesso deepfake è spesso l’unico dato su cui si può lavorare».

Keystone

KeystoneIl punto di forza: la possibilità di rintracciare la fonte - Il punto di forza messo a punto dagli studenti del Msu e dai ricercatori di Facebook, consiste proprio nel poter rintracciare la fonte creatrice di video diversi, pubblicati in tempi e piattaforme diverse, anche senza possedere una conoscenza preventiva del modello utilizzato per crearli. Sempre Hassner ha spiegato che «Il nostro metodo di reverse engineering si basa sulla scoperta dei modelli unici dietro il modello d'intelligenza artificiale utilizzato per generare una singola immagine. Con l’analisi del modello unico possiamo stimare la proprietà dei modelli generativi utilizzati per creare deepfake e persino associarne di più al modello che li ha eventualmente prodotti». Facebook, d’altra parte, si era già espresso contro i video manipolati, bandendoli dalla propria piattaforma.

Facebook annunciò interventi mirati - Ciò era avvenuto anche in occasione delle Presidenziali del 2020 e nel suo comunicato ufficiale aveva parlato d'interventi mirati contro i file modificati «in modi che non siano evidenti a un utente medio e che potrebbero ingannare qualcuno». I video deepfake, per loro stessa conformazione, sono infatti il mezzo più idoneo per diffondere, in maniera veloce, informazioni e notizie false capaci di gettare discredito sulla vita delle persone o, ancora, per convincerne altre della veridicità di fatti e notizie assolutamente falsi.

Deposit

DepositIl pericolo: un futuro in cui sia impossibile distinguere il vero dal falso - Il ricercatore d'intelligenza artificiale Alex Champandard si era espresso in maniera chiara sulla pericolosità di tale fenomeno dichiarando che «tutti dovrebbero sapere quanto velocemente le cose possono essere falsificate al giorno d’oggi con questa tecnologia», «Il problema è che l’umanità potrebbe cadere in un’epoca in cui non è più possibile determinare se il contenuto di un media corrisponde alla verità», ha affermato.

Un problema con radici antiche - Il problema è attuale ma ha radici più antiche di quel che si possa pensare. Alla metà di dicembre del 1986, nella rivista Analog, venne pubblicato ‘Picaper’ di Jack Woodhams in cui si parlava di video digitalmente migliorati o generati da hacker esperti a servizio del cattivo di turno. Nella storia, un video falso ma incredibilmente realistico veniva immesso in una videoconferenza e tale sistema poteva «seminare una confusione drastica e ottenere un drammatico colpo di stato». Il pericolo quanto mai reale, insomma, è quello di vivere una vita in cui realtà e menzogna si fondono senza distinzione e possibilità di riconoscimento. Con effetti disastrosi per tutti noi.